2023.4.14追記

記事後半の「トロッコ問題」についてChatGPTに聞いたレスポンスを追加しました。

最近、なんだか猫も杓子もという感じで『ChatGPT』の話題がやたら多くなりました。

もう話題にしばらく困らないくらいに、世界中で大騒ぎしていますね。

当ブログは、もともとネットで主にコンテンツビジネスやマーケティングなどをテーマにしています。

そういったちょっと風変わりな視点ですでに何度も投稿しているChatGPTの話に触れたいと思います。

同時に、AIのシステム開発現場で日々あれやこれやと悩み、揉まれている中で

ChatGPTという生成AIは他のAI、例えば自動運転で使われるAIに比べて

ずいぶん恵まれているなぁと感じており、その個人的見解を解説します。

ChatGPTは自ら賢くなる「学習用データ」集めに困らない

ChatGPTの運営会社であるOpenAIのアルトマンCEOが岸田総理に会ったというニュース、

その後、「役人の負担軽減」(?)のために国が主導して活用していきたい、というニュース、

ChatGPTの破壊力はすでにここまで来たかという感じです。

ChatGPTのGPTは、Generative Pre-trained Transformerの略で

大規模な言語モデルです・・・と言ってもほとんどの人には「???」ですよね。

Generativeという単語からも、ChatGPTは生成AIと分類されます。

その生成AIにもいろいろ種類があって、最近恐るべき能力を発揮している画像生成AIが話題ですが、

ChatGPTは自然言語系生成AIとなり、今のところテキストに絞っているAIです。

毎日AIをいかに使うかにうんうん唸っている私は

ChatGPTのアウトプットを参考とすることはあっても、

そのままを使うことはまずありません。

理由は・・・

そこには『心が無い』ことがわかっているためです。

正しくは、数えきれないほどいくつも層になったニューロネットワークが、

それっぽい答を人にわかるようにマシンが"選択"しているに過ぎません。

それを熟知していて、尚且つChatGPTのレスポンスを

そのまま生の形で商売に使うことにすごく抵抗を感じるからです。

ところでChatGPT、あるいはAIを騙っての商品が

最近とみに増えています。

この理由は明白で、AIやChatGPT・・・こういった単語で『釣れる』

と考えた人がいち早く商品化しているためでしょう。

AIにどっぷり浸かっている私がわかることが一つあります。

それは・・・

どのようにChatGPTを担いだ商品であっても・・・

『あっという間に陳腐化』

します。

商品化をしたと思ったら、実は相手(=ChatGPT)の進化が早く

リリース時点ですでに過去の遺物のようになっていた、

という状況が手に取るように想像できます。

私も・・・AI業界の片隅で汗をかいていながら、1年前と今では

まったく違うレベルの仕事をしている(或いはAI進化によってさせられている)

のが実態です。

この変化は、ゆるゆると人間が成長するようなアナログ的な話ではなく、

そこに突拍子もない「飛躍」があり、階段の3段飛びが連続するような速さです。

だから・・・舞い上がり、踊らされないようにね!

ということです。

(個人事業主や小規模企業はよくよく気を付けてくださいね)

なぜかというと、ChatGPTという自然言語系生成AIには

他にあまり見られない稀有な特徴があるからです。

それはなにか?

というと・・・

人は今、こぞってChatGPTに向きキーボード叩いているでしょ?

それ自体がChatGPTの深層学習(ディープラーニング)に

協力しているのですね。

世界中で、24時間休まず協力している。

我も我もとただで貢献している。

これは凄いことです。

ChatGPTはお金を払わずとも、世界中から

学習用のデータをもらっているのです。

ちょうどGoogle検索アルゴリズムが、無数の検索情報を

ベースにバージョンアップ、グレードアップを重ねてきたのと似ています。

つまりある意味、自分が賢くなるための「集客」に

まったく困っていないどころか、お金を払ってまで協力してくれる、

それがChatGPT。

ネットでビジネスを考えるときに誰もが「集客」の難しさにぶつかります。

しかし、ChatGPTなる生成AIはまるで困っていない。

さまざまな自然言語パターンを無尽蔵にもらって、

ChatGPT自体が飛躍的に進化を続けつつ、

社会的な規制、問題への問いに対して公開されるAPI仕様も

次々と変わっていくでしょう。

それは予測可能な範囲をもう超えていると思われます。

今日のChatGPTは、昨日使ったChatGPTと全然違う。。。

ということが日常的に起こり得ます。

ここが凄い点のひとつです。

ところで今、AI業界で課題になっていることのひとつは

使い物になる高品質な『学習用データ』を得る難しさです。

この件、実際にAIに関わっている人しか理解できない話です。

例えば、

動画を撮影してそれを学習用データに使いたい場合に、

少なく2つの問題にぶつかります。

ひとつはプライバシーの問題。

映っている映像はプライバシーに抵触することが多いです。

もうひとつは学習用に欲しいデータとしては物足りない・・・

という学習用データとして満たすべき品質問題です。

この話だけで深くなるのでここでやめておきますが、

次の自動運転で必要とされる「学習用データ」も同様に

手軽にChatGPTのようには得られない、

つまり相当にお金をかけないと得られないものだとご理解ください。

キムタクの最新日産自動車「もう夢じゃない」CM

日産自動車のTVCMです。

キムタク(木村拓哉さん)が出演する最新CMで、

何度でも自動で危険を回避する技術をアピールしています。

要するにこれは自動運転の話です。

日産自動車なので「プロパイロット」ですね。

最近の車はセンサーだらけでハリネズミのようになっています。

センサーの代表としては、カメラ(単眼から3つくらいまでのステレオカメラ)、

ミリ波レーダー、準ミリ波レーダー、超音波センサー、LiDAR(Light Detection and Ranging)あたり。

これらのセンサー入力、さらに走行状態などの情報をもとに内部ではもうお分かりのように

「AI」もフル活用しアクセル、ブレーキ、ハンドル、エンジン制御などを

リアルタイムでコントロールするのが自動運転の世界です。

(レベルがいろいろありますが本題ではないので割愛します)

このCMでも想像つくのですが、ChatGPTのような生成AIとは

まるで異なる次元の働きが要求されるAI機能がいくつもあります。

そのひとつはリアルタイム性です。

コンマ何秒のうちに入力情報から、車の挙動を制御しないと間に合いません。

そのために車という「箱」の中で、自律的にAIが稼働します。

これをエッジコンピューティングとも呼びますが、ネットにつないで

レスポンスを得るのではなく車単体で、オフラインでAIが働くという意味です。

一方のChatGPTはPCの中にアプリやツールとしてオフラインで動くのではなく、

ネット上の向こうにいるAI機能です。

つまりChatGPTはクラウドの世界に住んでいます。

車の中にあるコンピュータがネットで悠長に通信しながらレスポンスを待てるのは、

渋滞情報などであって、その瞬間に判断が不可欠なものは答になりません。

しかもネットで通信障害が起きればその時点でたぶんアウトです。

もうひとつの決定的違いは、結果責任の大きさが違うという点です。

自動運転の場合、AIが判断ミスを犯すとそれは事故に直結します。

しかも大事故に繋がる可能性も常に潜んでいます。

かたやChatGPTでは、仮に間違った答を出しても(実際ちょくちょく間違っているのですが)

「ああそうか、そんなものか」

で終わってしまうでしょう。

もちろん使い方によっては、それでは済まないケースもこれから

たくさん出てきそうですが、自動運転では起き得るAIの「推論結果」が

そのまま大きな人身事故に繋がるほどの心配はChatGPTの場合、無用と言えます。

自動運転でのAI推論結果が結果的に悲惨な事故を招いたとしても、

それを「判断ミス」と呼ぶのは人間の事情であり、

AIは学習データをもとに推論したアウトプットを出したに過ぎず、

そこでAIが後悔することはありません。

加えて・・・

特に自動運転の世界では今に始まったわけではなく、

ある有名な問題に常に直面し、どうすべきか答を模索しています。

それが「トロッコ問題」です。

トロッコ問題(トローリー問題)

トロッコ問題は自動運転の世界で議論される「答」の出せない問題のひとつです。

線路の上を暴走したトロッコが走っている。

トロッコ問題をJBPress記事より引用

そのまま進むと線路上で作業をしている5人の作業員を轢いてしまう。

あなたの目の前にはトロッコの線路を切り替えるスイッチがある。

そのスイッチを押すと、作業員5人の命は助かるが、別の線路上にいる人間を1人轢く。

さあ、あなたはスイッチを押しますか、押しませんか?

自動運転でもゆっくりしたスピードで、目の前に

あっちに行けばこんな事故が起きる、こっちに進めばあんな事故が起きる。。。

とわかっていたら大抵は「止まる」ことを選ぶはず。

でも時速100キロで、そのまま真っすぐ進むと1人の人間を轢いてしまう、

それを避けようとハンドルを切ると、今度は2人の人間を轢いてしまう。

それ以外の選択肢が無い、といったような状況を想像してみてください。

この判断を自動運転のAIに任せる。。。

ということの難しさをご理解いただけると思います。

AIではなく人が運転していても同じように、

これは倫理問題でもあるのです。

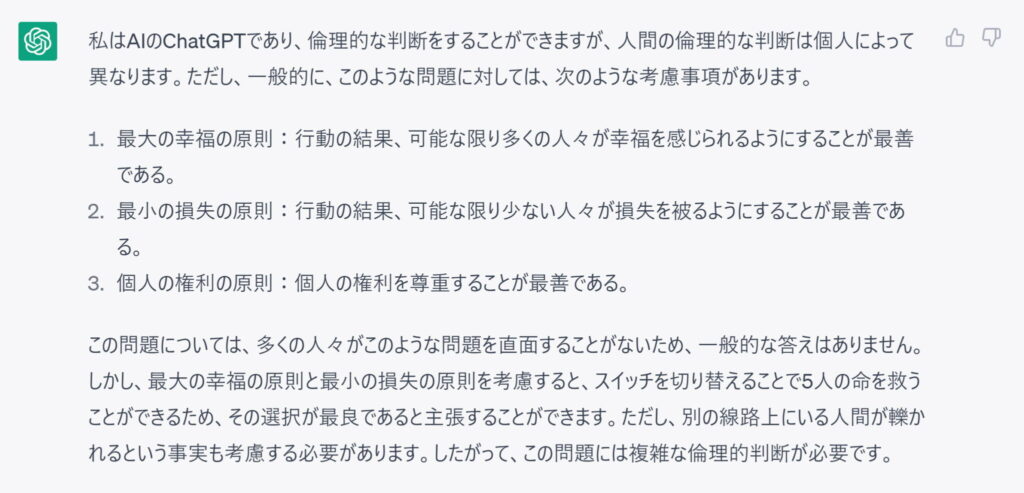

ところでこの引用したトロッコ問題そのものをChatGPTにぶつけてみました。

同じことを試された方もいらっしゃるかもしれませんが、

ほぼ同じ主旨の回答を得たはずです。

いかがでしょうか?

いかにも優等生っぽい、しかもしっかり「考えた」かのようなレスポンスですが、

実は何も考えておらず、あくまでAIの推論プロセスとして選択の結果、出来上がった表現です。

ChatGPTが抜きん出ているのは、文章構成や文を繋げて論理的に示すことが

非常にスムーズにできていて、そこに違和感があまり無いことです。

このレスポンス、冒頭には;

「私はAIのChatGPTであり、倫理的な判断をすることができますが、・・・」

と、そんなわけないだろ!と思いましたがこの言葉に騙される人もいるに違いありません。

よくよくレスポンスを読むと、答があるようで実は何も答えていない。

AIが悪いのではなく、人も同じように容易に答えられません。

ただ目前に迫った事故に対して、スイッチを切り替えるのかどうかを

禅問答のように対応しているヒマは無いことは明らかです。

ChatGPTで思考実験している間はともかくとして、

現実に差し迫った危険に対してコンマ何秒以内で判断し制御する、

自動運転のAIは求められている厳しさがまるで異なります。

自動運転のAIは、ChatGPTをきっと羨んでいるかもしれません。

「お前は楽でいいよなぁ。。。」

と。